Als GPT (Generative Pre-trained Transformer) zum ersten Mal in Marketingteams Einzug hielt, war es, als hätte uns jemand einen koffeinangetriebenen Praktikanten zur Seite gestellt, der niemals schläft, sich nie beschwert und selbstbewusst alle Fragen beantwortet. Texte schreiben? Kein Problem. Zusammenfassungen erstellen? Ein Kinderspiel. Strategisches Brainstorming? Aber sicher. Mit Aufzählungspunkten. Und Emojis. Viele Emojis... Wow!

Für einen Moment war es pure Magie.

Dann zeigten sich die ersten Risse. GPT begann, Quellen zu erfinden, Zahlen selbstbewusst falsch zu interpretieren und uns unsere eigenen Produkte falsch zu erklären. Und das auch noch mit zu viel Selbstvertrauen. Nichts zerstört das Vertrauen der Führungskräfte so sehr wie eine KI, die mit der Begeisterung eines Keynote-Speakers etwas Falsches sagt.

Das Problem war, dass wir ein Sprachmodell wie ein Marketing-System behandelt haben, wie eine geheime Zutat in unseren Marketingrezepten, die unsere potenziellen Kunden (und uns) glücklich machen sollte.

Aber die Wahrheit war bitter: Modelle im GPT-Stil sind brillant darin, plausible Sprache zu produzieren, nicht fundierte Wahrheit. Sie wissen nicht, was Ihr CRM heute sagt, wie Ihre Analytics heute Morgen aussah oder welche Zahlen die Rechtsabteilung gestern genehmigt hat. Sie sagen Texte voraus. Sie validieren nicht die Realität.

Und so kam es zu einer Reihe von Missverständnissen:

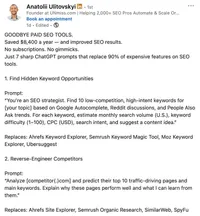

Der Beitrag wurde zum Hit. Über 500 Likes, mehr als 400 Kommentare und jede Menge Liebe. SEOs waren jedoch nicht beeindruckt...

Die Realität im Marketing ist chaotisch. Daten befinden sich in zu vielen Tools, ändern sich ständig und haben Konsequenzen, wenn sie falsch sind. Ein halluzinierter Witz ist lustig. Ein halluzinierter KPI in einer Präsentation vor dem Vorstand kann die Karriere beenden. Da begann in der Branche Ernüchterung einzusetzen.

Der eigentliche Wandel, der derzeit stattfindet, ist nicht der Wechsel von „schlechten Prompts” zu „besseren Prompts”. Es ist ein Wandel von der Sprachgenerierung hin zu entscheidungsfähigen Systemen. Systeme, die wissen, woher die Daten stammen, wie aktuell sie sind, was sie sagen dürfen und was als Nächstes geschehen sollte, sobald eine Antwort generiert wurde.

In Unternehmensumgebungen (und darüber hinaus) muss KI nicht nur intelligent klingen. Sie muss auch:

- nachverfolgbar

- überprüfbar

- konform

- wiederholbar

- und idealerweise korrekt sein (was an erster Stelle stehen sollte).

GPT ist ein fantastisches „Gehirn“. Das Marketing benötigt jedoch ein „vollständiges Nervensystem“, was bedeutet, dass das „Gehirn“ oder GPT ohne „Nerven“ oder Marketingdaten kein Bewusstsein für die Welt um sich herum hat.

Das „Nervensystem“ verbindet das „Gehirn“ mit realen Marketingdaten, überprüft Signale, bevor es reagiert, und verhindert, dass selbstbewusste Unsinnigkeiten Kunden, Führungskräfte oder Regulierungsbehörden erreichen. Genau hier kommen Architekturen wie RAG, Agenten und agentenbasierte Workflows ins Spiel.

Begeben wir uns in eine schöne neue Welt, in der Halluzinationen eher Museumsstücke als Produktionsrealitäten sind.

In diesem Artikel erfahren Sie:

- Warum GPT allein im Unternehmensmarketing an seine Grenzen stößt

- Was RAG tatsächlich behebt (und was nicht)

- Wie KI-Agenten Antworten in Handlungen umsetzen

- Warum „agentisches RAG” kein Modewort, sondern eine strukturelle Verbesserung ist

- Wann Fine-Tuning und LoRA sinnvoll sind (und wann sie es absolut nicht sind)

- Wie man über KI-Architekturentscheidungen wie ein Systemdesigner denkt, nicht wie ein Prompt-Ingenieur

Die Realität der Marketingdaten

Bevor ich über Architekturen, Modelle oder irgendetwas mit dem Wort „agentic” spreche, muss ich etwas tun, das mir etwas unangenehm ist: mir ansehen, wie Marketingdaten in realen Unternehmensumgebungen tatsächlich aussehen.

Spoiler-Alarm: Sie sehen nicht wie eine saubere CSV-Datei aus, die höflich darauf wartet, von einer KI analysiert zu werden. Unternehmensmarketingdaten sind überall gleichzeitig zu finden.

- CRM-Systeme mit halb ausgefüllten Feldern...

- Analytics-Plattformen, die sich über die Attribution streiten...

- SEO-Datensätze, gemessen in Millionen von Keywords...

- Content-Bibliotheken, die seit dem letzten Rebranding nicht mehr bereinigt wurden...

- PR-Erwähnungen, verstreut über Nachrichtenseiten, Foren und soziale Plattformen...

- Täglich aktualisierte Produkt-Feeds...

- Rechtliche Einschränkungen, die still im Hintergrund lauern und bereit sind, im ungünstigsten Moment alles lahmzulegen...

Und all das ändert sich... ständig. Marketingdaten sind kein statisches Wissen. Sie sind ein bewegliches Ziel mit Meinungen.

Genau hier beginnen GPT-Modelle zu kämpfen. Sie werden anhand von Momentaufnahmen des Internets aus der Vergangenheit trainiert. Sie wissen nicht, wie Ihre Conversion Rate gestern war, welche Kampagne die Rechtsabteilung heute Morgen genehmigt hat oder welche Produktfunktion in Deutschland nicht mehr erwähnt werden darf, in Spanien aber völlig in Ordnung ist.

Statische Modelle versagen in dynamischen Umgebungen, weil sie kein Gespür für das Jetzt haben. Sie generieren Antworten, als wären Zeit, Kontext und Verantwortung optional.

Die Kosten einer falschen Antwort sind hier nicht theoretischer Natur. Sie sind praktisch und schmerzhaft:

- Falsche Zielgruppen-Ansprache bedeutet verschwendete Medienausgaben

- Falsche Erkenntnisse führen zu schlechten strategischen Entscheidungen

- Veraltete Botschaften führen zu Inkonsistenzen der Marke

- Halluzinierte Fakten können zu Reputations- oder Rechtsrisiken eskalieren (haben Sie von dem berühmten Misserfolg einer bekannten Beratungsfirma gehört? Schauen Sie sich einfach diese Quelle an: https://fortune.com/2025/10/07/deloitte-ai-australia-government-report-hallucinations-technology-290000-refund/)

An dieser Stelle kommt RAG (Retrieval Augmented Generation) ins Spiel.

Evergreen-Übersicht über die Kernkomponenten der KI (konzeptionelle Karte)

Es ist gefährlich leicht, Begriffe zu verwechseln und versehentlich zu glauben, man habe ein System, obwohl man in Wirklichkeit nur eine sehr zuverlässige Autovervollständigung hat.

Dieser Abschnitt ist ein Glossar, aber vor allem auch eine Möglichkeit, zu verhindern, dass Marketing, IT und Führung aneinander vorbeireden, obwohl sie alle dieselben Schlagworte verwenden.

LLMs (Large Language Models)

Beginnen wir mit den Grundlagen.

LLMs sind in einer Sache extrem gut: Sie können das nächste Token in einer Sequenz auf Grundlage von Wahrscheinlichkeiten vorhersagen. Das ist alles. Alles andere ist ein Nebeneffekt dieser einen Sache, die in großem Maßstab durchgeführt wird.

Sie glänzen, wenn die Aufgabe unklar, kreativ oder explorativ ist. Wenn Sie zehn Möglichkeiten benötigen, um ein Konzept zu erklären, einen Absatz umzuschreiben oder Ideen für eine Kampagne zu sammeln, sind LLMs fantastisch.

Wofür sie nicht entwickelt wurden:

- Wissen, was gerade wahr ist

- Validierung von Fakten anhand von Live-Systemen

- Verständnis von Geschäftsregeln oder Compliance-Beschränkungen

- Übernahme von Verantwortung für Entscheidungen

LLMs haben keinen Zugriff auf Ihre (oder andere) Daten, es sei denn, Sie geben ihnen diesen ausdrücklich. Sie wissen nicht, welche Quelle korrekt ist. Sie wissen nicht, wann sie falsch liegen. Und sie wissen absolut nicht, wann eine Antwort Sie in Schwierigkeiten bringen könnte.

Aus diesem Grund führt die Verwendung eines „größeren Modells” selten zu besseren Geschäftsergebnissen. Größere Modelle sind besser in der Sprache, nicht in der Verantwortlichkeit. Die Wahrheit ist, dass sie flüssiger halluzinieren, aber nicht genauer werden.

GPT als Schnittstelle, nicht als System

GPT lässt sich am besten als Schnittstelle zur Sprachintelligenz verstehen, nicht als Marketing-System. Es handelt sich um eine Konversationsschicht, die auf einem Modell aufsetzt und die Interaktion für Menschen vereinfacht. Deshalb hat es sich so schnell verbreitet.

Kein Training. Keine Einarbeitung. Einfach tippen und loslegen.

Als Schnittstelle eignet sich GPT hervorragend für:

- Ideenfindung und Brainstorming

- Entwurf von Content

- Zusammenfassung langer Dokumente

- Als Denkpartner

Es verringert die Reibung zwischen Menschen und komplexen Modellen, was eine enorme Leistung ist. Strukturell gesehen weist GPT jedoch erhebliche Einschränkungen für die Arbeit mit Marketingdaten auf. Es verfügt über kein integriertes Verständnis Ihrer internen Datenquellen, der Aktualität der Daten, der Datenhoheit, der Genehmigungsworkflows, der Marken- oder rechtlichen Beschränkungen und vieles mehr...

Mit anderen Worten: GPT ist hervorragend geeignet, um über Marketing zu sprechen. Aber es ist nicht darauf ausgelegt, Marketing zu betreiben.

Retrieval-Augmented Generation (RAG): Der erste echte Sprung

Irgendwann kommt jedes ernsthafte Marketingteam zu derselben Erkenntnis: Das Problem ist nicht, dass das Modell nicht sprechen kann. Das Problem ist, dass es unsere Inhalte nicht kennt.

Das war der Moment, in dem KI aufgehört hat, ein cleverer Papagei zu sein, und sich eher wie ein Junior-Analyst zu verhalten, der zumindest die Dokumente überprüfen muss, bevor er antwortet.

Was RAG tatsächlich löst

Anstatt das Modell zu bitten, aus seinen Trainingsdaten und vagen Erinnerungen aus dem Internet zu antworten, zwingen Sie es dazu

- relevante Informationen aus Ihren eigenen vertrauenswürdigen Quellen abzurufen.

- eine Antwort auf der Grundlage dieser Informationen zu generieren.

Das verändert sofort drei Dinge.

Erstens: Fundierung.

Die Antworten basieren auf echten, aktuellen Daten: Ihren CRM-Exporten, Analytics-Berichten, Inhaltsbibliotheken, Produktdokumentationen, PR-Erwähnungen oder internen Richtlinien. Das Modell rät nicht mehr, wie Ihre Marke klingt. Es liest es buchstäblich.

Zweitens: Reduzierung von Halluzinationen.

Halluzinationen verschwinden nicht vollständig (bitte lesen Sie das noch einmal), aber sie lassen sich viel leichter erkennen und kontrollieren. Wenn eine Antwort falsch ist, können Sie sie bis zur Quelle zurückverfolgen. Wenn eine Quelle fehlt, wissen Sie genau, warum die Antwort schwach ist. Allein das ist ein großer Fortschritt für das Vertrauen in Unternehmen.

Drittens: Trennung von Wissen und Schlussfolgerungen.

Dies ist der am meisten unterschätzte Vorteil. Das Wissen befindet sich in Ihren Systemen. Das Denken befindet sich im Modell. Sie können Daten aktualisieren, ohne das Modell neu zu trainieren, und das Denken verbessern, ohne Ihren Content neu zu schreiben. Diese Trennung macht RAG skalierbar.

Plötzlich fühlen sich die Ergebnisse der KI nicht mehr wie Meinungen an, sondern wie Analysen.

Warum Basic RAG immer noch nicht ausreicht

RAG fühlt sich wie ein Durchbruch an. Und im Vergleich zu Raw GPT ist es das auch. Die Antworten sind fundiert, die Quellen sind sichtbar und Halluzinationen werden endlich an die Leine genommen.

Dann versuchen Teams, es für echte Marketingarbeit zu nutzen, und da zeigt sich die nächste Einschränkung.

Basic RAG eignet sich hervorragend, um jeweils eine Frage zu beantworten. Leider funktioniert Marketing so nicht. Die meisten Marketingfragen sind gar keine Fragen. Es handelt sich um Prozesse, die als Fragen getarnt sind: „Welche Themen sollten wir priorisieren?“, „Warum ist die Leistung gesunken?“, „Was sollten wir als Nächstes tun?“.

Das sind keine einmaligen Abfragen. Sie erfordern mehrere Schritte, Kompromisse, Kontext und Urteilsvermögen. Das grundlegende RAG kann das nicht. Es ruft Informationen ab, gibt Antworten und vergisst dann alles, was es gerade getan hat. An diesem Punkt verschiebt sich die eigentliche Frage erneut. Nicht „Wie erhalten wir bessere Antworten?“, sondern „Wie bauen wir Systeme auf, die schrittweise denken, Ziele speichern und innerhalb von Beschränkungen arbeiten können?“

Marketing führt Prozesse durch. Und Prozesse erfordern mehr als nur das Abrufen und Generieren von Informationen.

KI-Agenten oder der Sprung von Antworten zu Handlungen

Ein KI-Agent ist keine intelligentere Eingabeaufforderung und kein Chatbot mit Autonomievorstellungen. Es handelt sich um ein Systemdesignmuster. Im Kern ist ein Agent zielorientiert. Anstatt eine einzelne Frage zu beantworten, arbeitet er auf ein Ziel hin. „Verbesserung der Content-Abdeckung.“ „Überwachung der Markensichtbarkeit.“ „Erkennung von Leistungsanomalien.“ Das Ziel geht über eine einzelne Interaktion hinaus.

Agenten sind standardmäßig werkzeugorientiert. Sie reden nicht nur. Sie fragen Analytics-Plattformen ab, rufen CRM-Daten ab, führen SEO-Crawls durch, überprüfen Dashboards und holen Dokumente ein.

Agenten sind speicherbewusst. Sie erinnern sich daran, was sie bereits überprüft haben, was beim letzten Mal fehlgeschlagen ist und welche Einschränkungen gelten. Allein dadurch entfällt ein großer Teil der sich wiederholenden menschlichen Überwachung.

Am wichtigsten ist, dass Agenten planen und iterieren können. Sie unterteilen ein Ziel in einzelne Schritte, führen diese aus, bewerten die Ergebnisse und nehmen Anpassungen vor. Wenn etwas keinen Sinn ergibt, können sie es mit einem anderen Ansatz erneut versuchen, statt sich mit der ersten mittelmäßigen Antwort zufriedenzugeben.

Agenten im Marketingkontext

Agenten können in Marketingumgebungen kontinuierlich Leistungssignale über verschiedene Kanäle hinweg überwachen und Anomalien im Traffic, in Rankings, Conversions oder der Stimmung melden, bevor ein Mensch sie bemerkt. Keine Dashboards. Keine täglichen Überprüfungen.

Agenten können wiederkehrende Analysen durchführen, die Menschen normalerweise aufschieben: wöchentliche Überprüfungen der SEO-Abdeckung, monatliche Erkennung von Content-Verfall, kontinuierliche Überwachung der Konkurrenz. Die Art von Arbeit, die wertvoll ist, aber selten Priorität hat, weil sie langweilig und zeitaufwändig ist.

Agenten können sich auch hervorragend für die Koordination mehrerer Tools eignen. Sie können Daten aus Analytics-Plattformen abrufen, sie mit SEO-Datensätzen anreichern, die CRM-Leistung überprüfen und Erkenntnisse aus Systemen zusammenfassen, die normalerweise nicht miteinander kommunizieren.

Hier beginnt KI, sich weniger wie eine Neuheit und mehr wie ein Teammitglied anzufühlen. Nicht als Ersatz für Marketingfachleute, sondern als Verstärkung für die Analytics-Fähigkeit.

Allerdings sind Agenten nur so gut wie die Informationen, auf deren Grundlage sie handeln. Wenn sie sich auf vage oder halluzinierte Kenntnisse stützen, automatisieren sie Fehler einfach schneller.

Deshalb reichen Agenten allein auch nicht aus, und hier wird es wirklich interessant.

Agentische KI und agentisches RAG

Wenn GPT „intelligenter Text” und RAG „intelligenter Text mit Quellen” waren, dann ist agentische KI das, was endlich anfängt, wie Arbeit auszusehen.

Agentische KI ersetzt die Prompt-Denkweise durch eine Entscheidungsschleife.

Anstelle von: Frage → Antwort → Fertig

erhalten Sie: Planen → Ausführen → Validieren → Anpassen → Wiederholen

In der Praxis bedeutet das, dass ein Agent – natürlich implizit – sagen kann: „Ich bin mir noch nicht sicher. Ich muss drei Quellen überprüfen, Zeiträume vergleichen und die Definition der Metrik überprüfen, bevor ich mich äußere.“ (Was, ehrlich gesagt, mehr Dashboards meiner Meinung nach tun sollten).

Agentische RAG

Kombinieren Sie diese Entscheidungsschleife mit RAG, und Sie erhalten die Architektur, die sich die meisten Marketingteams in Unternehmen tatsächlich wünschen, auch wenn sie sie noch nicht so nennen.

Agentische RAG bedeutet, dass RAG nicht mehr „das System“ ist. Es ist eine Fähigkeit innerhalb des Systems. Anstatt etwas einmal abzurufen und zu generieren, kann der Agent es über einen mehrstufigen Workflow hinweg mehrfach abrufen.

Beispielmuster:

- Analytics für den relevanten Zeitraum abrufen.

- Kampagnennotizen und Tracking-Definitionen abrufen.

- Mit CRM-Ergebnissen abgleichen.

- Markenrichtlinien für Messaging-Beschränkungen abrufen.

- Erkenntnisse + empfohlene Maßnahmen generieren.

- Überprüfen, ob die Empfehlung mit den Zielen und Regeln übereinstimmt.

KI-Workflows: Skalierung über einen Agenten hinaus

Ein Agent ist beeindruckend, zwei Agenten sind interessant, aber ein Workflow von Agenten ist der Punkt, an dem Unternehmen endlich aufhören zu experimentieren und anfangen, etwas aufzubauen, das länger als ein Quartal überdauert.

Echte Marketing-Systeme werden nicht von einer einzigen, allwissenden KI angetrieben. Sie sind als orchestrierte Workflows aufgebaut, bei denen mehrere Agenten verschiedene Teile des Prozesses übernehmen, ähnlich wie es ein echtes Team tut. Die effektivsten KI-Workflows spiegeln wider, wie starke Marketing-Teams tatsächlich arbeiten.

Sie haben:

- Recherche-Agenten, die Daten aus Analytics, SEO-Plattformen, CRM-Systemen und externen Quellen abrufen.

- Validierungsagenten, die Definitionen, Zeitbereiche, Aktualität der Daten und Konflikte überprüfen.

- Syntheseagenten, die strukturierte Ergebnisse in Erkenntnisse, Empfehlungen oder Erzählungen umwandeln.

Diese Spezialisierung ist wichtig. Sie verhindert voreilige Schlussfolgerungen, reduziert Halluzinationen und schafft natürliche Kontrollpunkte für Qualität und Compliance.

Mit anderen Worten: Sie hören auf, von einem Agenten zu verlangen, gleichzeitig Stratege, Analyst, Auditor und Texter zu sein.

Feinabstimmung, LoRA und wann sie tatsächlich Sinn machen

Jede KI-Diskussion kommt irgendwann an denselben Punkt. Jemand lehnt sich zurück und sagt: „Okay, aber was wäre, wenn wir das Modell einfach feinabstimmen würden?“ Das wird normalerweise mit dem gleichen Tonfall gesagt, mit dem man früher fragte: „Was wäre, wenn wir die Website einfach von Grund auf neu aufbauen würden?“ Es klingt entschlossen. Und es ist sehr oft der falsche erste Schritt.

Lassen Sie uns ein paar Mythen aufklären.

Feinabstimmung

Feinabstimmung bedeutet, die interne Gewichtung eines Modells so anzupassen, dass es sich anders verhält. Nicht intelligenter. Einfach anders.

Feinabstimmung ist nützlich, wenn Sie ein konsistentes Verhalten oder einen konsistenten Stil über viele Ausgaben hinweg benötigen. Zum Beispiel:

- Durchsetzung einer bestimmten Markenstimme

- Standardisierung von Antwortformaten

- Verbesserung der Leistung bei engen, sich wiederholenden Aufgaben

Es ist besonders effektiv, wenn die Aufgabe stabil ist und sich die Daten nicht häufig ändern. Allerdings ist Fine-Tuning eine schlechte Lösung für Probleme, die durch fehlende oder sich ändernde Daten verursacht werden. Es bewirkt Folgendes nicht:

- Das Modell auf den neuesten Stand bringen

- Ihm Ihre Analytics-Daten beibringen

- Halluzinationen beheben, die durch fehlende Grundlagen verursacht werden

- Datenzugriff oder -validierung ersetzen

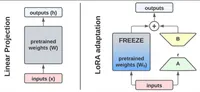

LoRA (Low-Rank Adaptation)

LoRA wurde entwickelt, weil Unternehmen einige Vorteile der Feinabstimmung ohne den damit verbundenen hohen Aufwand nutzen wollten. Es ermöglicht eine leichte Anpassung großer Modelle, indem nur eine kleine Anzahl zusätzlicher Parameter trainiert wird, anstatt das gesamte Modell zu verändern. Stellen Sie sich das wie das Hinzufügen einer Linse vor, nicht wie eine Neuverdrahtung des Gehirns.

Quelle: https://pub.towardsai.net/low-rank-adaptation-lora-fedf37b92026

LoRA ist attraktiv, weil:

- Es ist kostengünstiger und schneller als eine vollständige Feinabstimmung

- Es kann leicht ausgetauscht oder zurückgesetzt werden

- Es ermöglicht mehrere Anpassungen am gleichen Basismodell

- Es passt besser in kontrollierte Bereitstellungspipelines

Für Unternehmen bedeutet dies mehr Flexibilität und weniger Bindung.

Gleichzeitig ersetzt LoRA nicht:

- RAG für die Verankerung von Antworten in Live-Daten

- Agentische Workflows für mehrstufige Schlussfolgerungen

- Governance für Compliance und Risikokontrolle

LoRA verändert, wie das Modell spricht oder sich verhält. Es verändert nicht, was es derzeit weiß, woher dieses Wissen stammt oder warum eine Entscheidung getroffen wurde.

Nun bleibt die letzte Frage: Wie wählen Sie bei all diesen Optionen die richtige Konfiguration aus, ohne Ihren Stack in ein KI-Forschungsprojekt zu verwandeln? Hier kommen Vergleichs- und Entscheidungsrahmen ins Spiel.

Auswahl von KI-Architekturen, die echte Marketingwirkung erzielen

Es gibt leider keine universell „beste“ Architektur. Es gibt nur Architekturen, die für den jeweiligen Zweck geeignet sind, und Architekturen, die in Demos beeindruckend aussehen, aber still und leise operative Schulden verursachen. Anstatt über Meinungen zu diskutieren, vergleichen wir sie anhand von Dimensionen, die im Marketing tatsächlich relevant sind.

Architektur-für-Architektur-Realitätscheck

| Architektur | Datenaktualität | Genauigkeit & Vertrauen | Skalierbarkeit | Betriebskosten | Risikokontrolle | Zeit bis zur Erkenntnis | Realitätscheck |

| GPT-only | Sehr niedrig | Fragil | Hoch für Sprache, niedrig für Realität | Geringe Anfangskosten, hohe Folgekosten | Nahezu keine | Schnell (bis Menschen verifizieren) | Gut für Ideation und Entwürfe. Gefährlich für Entscheidungen. Menschliche Überprüfung frisst stillschweigend alle Zeitersparnisse. |

| GPT + Fine-Tuning | Niedrig | Leicht verbessert | Mittel | Mittel bis hoch | Teilweise | Schnell für eng begrenzte Aufgaben | Verbessert Konsistenz und Ton. Löst weder Verankerung noch Aktualität. Wird oft als „strategisches“ Upgrade überverkauft. |

| RAG | Hoch | Strank | Gut mit soliden Pipelines | Mittel | Moderat | Gut | Erste Architektur, die sich unternehmenssicher anfühlt. Immer noch meist Single-Shot und menschlich orchestriert. |

| Agent + RAG | Hoch | Hoch | Gut | Höhere Anfangskosten, langfristig geringer | Stark | Sehr gut | KI beginnt sich wie ein Analyst zu verhalten. Führt Ziele, Gedächtnis und Iteration ein. |

| Agentic RAG + Workflows | Hoch | Sehr hoch | Exzellent | Höhere Anfangskosten, niedrigste Kosten im Skaleneinsatz | Unternehmensgrad | Am schnellsten bei Skalierung | Liefert kumulativen Mehrwert. Für die Realität gebaut, nicht für Demos. Übersteht Komplexität und Wachstum. |

So wählen Sie die richtige Architektur (Entscheidungsrahmen)

Nach all den Architekturen, Abkürzungen und Diagrammen ist die gefährlichste Frage, die ein Unternehmen stellen kann: „Welche sollen wir kaufen?“

Das ist die falsche Frage. Die richtige Frage lautet: Welche Architektur passt zu unserer aktuellen Situation, ohne das Vertrauen, das Budget oder die Teams zu gefährden?

Reife des Teams

Beginnen Sie mit Menschen, nicht mit Modellen.

Wenn Ihre Teams noch experimentieren und lernen, wie KI in die tägliche Arbeit passt, und sie hauptsächlich für Support-Aufgaben einsetzen, wird der direkte Sprung in agentenbasierte Workflows überwältigend sein. Die Architektur sollte die Teams leicht herausfordern, aber nicht überfordern.

Datenkomplexität

Nächste Frage: Wie unübersichtlich sind Ihre Daten?

Wenn die Marketingdaten zentralisiert, gut dokumentiert und einigermaßen sauber sind, können einfachere Architekturen funktionieren. Wenn die Daten über Regionen, Marken, Tools und Definitionen fragmentiert sind, steigt die Komplexität schnell an.

Risikotoleranz

An dieser Stelle werden Unternehmensgespräche sehr schnell sehr ehrlich.

Fragen Sie sich

- Was passiert, wenn die KI falsch liegt?

- Wer genehmigt die Ergebnisse?

- Handelt es sich um interne Erkenntnisse oder um kundenorientierten Content?

Umgebungen mit geringer Risikotoleranz erfordern:

- Rückverfolgbarkeit

- Audit-Protokolle

- Eingebettete Einschränkungen

Umgebungen mit hoher Risikotoleranz können sich mehr Autonomie leisten, aber nur, wenn sie die Konsequenzen akzeptieren.

Geschwindigkeit vs. Tiefe

Wenn Geschwindigkeit am wichtigsten ist, liefern einfachere Systeme schnelle Erfolge. Wenn Tiefe am wichtigsten ist, wird mehrstufiges Denken unvermeidlich.

Hinweis: Unternehmen benötigen in der Regel beides, aber nicht für die gleichen Aufgaben.

Experimentieren vs. Produktion

Experimentieren und Produzieren sind oft schwer voneinander zu unterscheiden, und viele Teams überschreiten diese Grenze, nur um es später zu bereuen.

Experimentieren erfordert eine schnelle Einrichtung, flexible Eingabeaufforderungen und minimale Kontrolle, während die Produktion Stabilität, Wiederholbarkeit und Verantwortlichkeit erfordert.

Die meisten KI-Fehler treten auf, wenn experimentelle Setups ohne die notwendigen architektonischen Upgrades stillschweigend in die Produktion übernommen werden. Wenn das System wichtig ist, bauen Sie es so, als wäre es wichtig.

Die einfache Faustregel

Wenn Sie sich nichts anderes merken können, merken Sie sich das:

- Wenn Antworten wichtig sind → RAG

- Wenn Entscheidungen wichtig sind → Agenten

- Wenn Ergebnisse wichtig sind → Agentic RAG + Workflows

GPT allein hilft Ihnen, über Marketing zu sprechen; RAG hilft Ihnen, Marketing zu verstehen; Agentic-Systeme helfen Ihnen, Marketing zu betreiben.

Das ist der Unterschied zwischen Neugier und Fähigkeit.

Zusammenfassung

Wenn es eine Idee gibt, die ich Ihnen mit auf den Weg geben möchte, dann diese: Die Zukunft der KI im Marketing liegt nicht in besseren Prompts.

Marketingleiter, die KI wie Zauberei behandeln, werden weiterhin Pilotprojekte durchführen.

Marketingleiter, die KI wie Software behandeln, werden Fähigkeiten aufbauen.

KI wird immer besser werden. Modelle werden sich weiter verbessern. Das ist unvermeidlich. Nicht unvermeidlich ist jedoch, wie viel Wert Sie daraus ziehen. Wenn Sie KI wie Software (und nicht wie Zauberei) gestalten, sind Sie auf der Gewinnerseite.

- Wenn Sie immer noch über Eingabeaufforderungen diskutieren, sind Sie noch zu früh dran.

- Wenn Sie Architekturen entwerfen, sind Sie bereits einen Schritt voraus.

- Wenn Ihre KI-Ergebnisse nachvollziehbar, validierbar und wiederholbar sind, bauen Sie eine echte Marketing-Infrastruktur auf.

Und wenn dieser Artikel Ihnen geholfen hat, neu darüber nachzudenken, wie KI im Marketing tatsächlich funktionieren sollte, dann ist der nächste Schritt nicht ein weiteres Tool, sondern ein besseres Systemdesign.

Bei Digital Loop arbeiten wir an komplexen MarTech-Lösungen für Unternehmen, die für den realen Einsatz konzipiert sind. Das bedeutet, dass wir über isolierte KI-Experimente hinausgehen und Systeme entwickeln, die nachvollziehbar, überprüfbar und produktionsreif sind.

Wenn Sie KI von beeindruckenden Demos in messbare Marketingeffekte umwandeln möchten, ist dies genau die Art von Arbeit, auf die wir uns konzentrieren. Lassen Sie uns darüber sprechen, wie dies in Ihrem Unternehmen aussehen könnte. Schreiben Sie uns hier