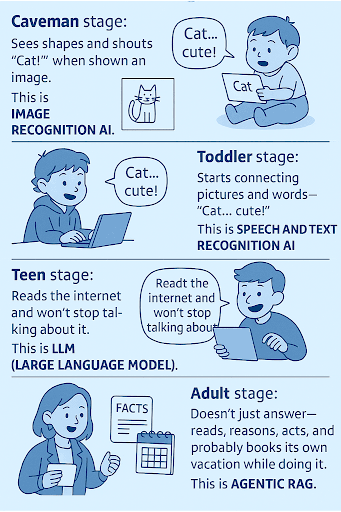

RAG? Agentic RAG? Ich weiß, ich weiß ... In letzter Zeit sind viele neue Definitionen aufgetaucht, aber das ist unsere neue Realität. In nur wenigen Jahren hat sich KI rasant weiterentwickelt und sich von einer einfachen Worterkennung zu wirklich leistungsstarken Systemen gewandelt.

So sieht diese Entwicklung aus:

- Höhlenmenschen-Stadium: Sieht Formen und ruft „Katze!”, wenn ihm ein Bild gezeigt wird. Das ist Bildverarbeitungs-KI.

- Kleinkind-Stadium: Beginnt, Bilder und Wörter wie „Katze... süß!” miteinander zu verbinden. Das ist Sprach- und Texterkennungs-KI.

- Teenager-Stadium: Liest im Internet und redet ununterbrochen darüber. Das ist LLM (Large Language Model).

- Studenten-Stadium: Lernt, Fakten zu überprüfen, bevor er damit prahlt. Das ist RAG (Retrieval-Augmented Generation).

- Erwachsenen-Stadium: Antwortet nicht nur, sondern liest, argumentiert, handelt und bucht dabei wahrscheinlich seinen eigenen Urlaub. Das ist Agentic RAG.

Nun, wenn wir vor einigen Monaten noch dachten, dass RAG (Retrieval-Augmented Generation) die endgültige Antwort auf alle Probleme der KI sei, erkennen wir heute, dass RAG nur der Anfang ist.

Zurzeit entsteht eine neue Idee: Agentic RAG. Das ist etwas, das die Art und Weise verändern wird, wie wir Einkäufe im Internet tätigen (und nicht nur Einkäufe). Anstatt passiv Schnipsel abzurufen und zu hoffen, dass das Modell richtig liegt, plant, überprüft und handelt ein agentiales System (was wichtig ist, um bekannte Halluzinationen zu vermeiden). Es überlegt, was es braucht, holt es sich, überprüft es und führt sogar kleine Aufgaben aus, um die Ergebnisse zu bestätigen.

Während traditionelles RAG wie ein hilfsbereiter Bibliothekar ist, der dir Dokumente reicht, ist Agentic RAG der Forscher, der diese Dokumente liest, die Zahlen überprüft und eine Schlussfolgerung entwirft, der Sie vertrauen kann.

Und die gute Nachricht? Sie brauchen keinen Doktortitel in Vektordatenbanken, um die Grundlagen seiner Funktionsweise zu verstehen.

In diesem Beitrag erfahren Sie:

- Was Retrieval Augmented Generation (RAG) eigentlich macht (in einfacher Sprache, ohne technische Fachbegriffe, hoffe ich).

- Warum Agentic RAG die nächste Evolutionsstufe ist, die das Abrufen von Informationen in Schlussfolgerungen und Handlungen umwandelt.

- Wie eine Agentic-RAG-Schleife Schritt für Schritt funktioniert: Planen, Abrufen, Schlussfolgern, Handeln und Überprüfen.

- Ich werde Beispiele aus der Praxis vorstellen, wie Unternehmen Agentic RAG in den Bereichen SEO, Analytics und Wissensmanagement anwenden können (und es bereits tun).

- Sie werden die größten Herausforderungen und Fallstricke kennenlernen (wie Kontextdrift, Kosten und Overengineering-Fallen).

Also schnallen Sie sich an und lass uns den Fachjargon beiseite lassen, um zu sehen, was wirklich hinter dieser nächsten Evolutionsstufe des KI-Schlussfolgerns steckt.

RAG? Agentic RAG? Aber... was ist der Unterschied?

Beginnen wir mit den Grundlagen.

Große Sprachmodelle sind unglaublich gut darin, flüssige Texte zu generieren, aber sie haben einen entscheidenden Nachteil: Sie „wissen” nichts, was nicht in ihren Trainingsdaten enthalten war. Wenn Ihr Unternehmen letzte Woche ein neues Produkt auf den Markt gebracht oder gestern seine Preise aktualisiert hat, hat das Modell keine Ahnung davon.

Hier kommt Retrieval-Augmented Generation (RAG) ins Spiel.

Retrieval-Augmented Generation (RAG) bezeichnet den Ansatz, Generative KI-Modelle mit aktuellem Wissen aus externen Datenquellen zu versorgen.

Die Idee dahinter ist einfach:

- Wenn Sie eine Frage stellen, ruft das System die relevantesten Informationen aus Datenquellen wie Websites, Dokumenten, Datenbanken oder Wikis ab.

- Es fügt diese Schnipsel in die Eingabeaufforderung des Modells ein.

- Dann generiert das Modell eine Antwort, die auf diesem neuen, abgerufenen Kontext basiert.

Im Grunde handelt es sich um einen Mechanismus, der für LLMs eine „Faktenprüfung vor dem Sprechen“ darstellt.

Traditionelles RAG funktioniert in drei Schritten: Abrufen, Ergänzen, Generieren. Wenn Sie eine Frage stellen, durchsucht das System eine Datenbank oder Dokumentensammlung, findet den relevantesten Text und fügt diese Ausschnitte in die Eingabeaufforderung des Modells ein. Anschließend schreibt das Modell seine Antwort auf der Grundlage dieses Kontexts.

Wie viele Teams jedoch schnell feststellen, hat RAG seine Grenzen. Es handelt sich um eine statische Pipeline. Sobald die Dokumente abgerufen wurden, akzeptiert das Modell sie als Wahrheit und schreibt eine Antwort, auch wenn die Daten unvollständig oder widersprüchlich sind. Es hinterfragt nicht die Qualität der abgerufenen Informationen. Für einfache Anwendungsfälle (wie die Beantwortung von FAQs) ist das in Ordnung, aber wenn Aufgaben logisches Denken, Gegenprüfungen oder mehrstufige Analysen erfordern, versagt es.

Und genau hier kommt Agentic RAG ins Spiel.

Anstatt das Abrufen als einmaligen Schritt zu behandeln, verwandelt es den Prozess in eine Schleife aus Schlussfolgerungen und Aktionen. Die KI nimmt nicht einfach alles, was abgerufen wird. Sie entscheidet, was gesucht werden soll, wie es interpretiert werden soll und was als Nächstes zu tun ist, wenn die Informationen nicht eindeutig sind.

Stellen Sie sich das so vor:

- Klassisches RAG ist wie ein Bibliothekar, der Ihnen aufgrund Ihrer Frage einen Stapel Bücher bringt.

- Agentic RAG ist ein Forscher, der diese Bücher liest, die Daten vergleicht, Berechnungen durchführt und dann eine fundierte Schlussfolgerung formuliert.

Das ist ein kleiner konzeptioneller Schritt, aber ein großer Sprung, der die KI von einem Inhaltsgenerator zu einem Entscheidungspartner macht.

Genauer betrachtet: Der Agentic RAG-Kreislauf (Wie es tatsächlich funktioniert)

Wenn traditionelles RAG eine einspurige Straße ist, auf der Eingaben eingehen und Antworten ausgegeben werden, ist Agentic RAG ein ringförmiges Autobahnsystem mit mehreren Ausfahrten und Kontrollpunkten.

Das Modell greift nicht einfach Informationen auf und antwortet. Es durchläuft einen kleinen Zyklus von Argumentationsschritten, bevor es überhaupt mit dem Schreiben beginnt.

Was seine Logik angeht, folgt der Agentic RAG-Loop auf hoher Ebene fünf Phasen:

1. Planen: In diesem Schritt entscheidet der Agent, was er wissen muss.

Anstatt sich vollständig auf Ihre Eingabe zu verlassen, unterteilt er die Frage in Teilziele.

Beispiel: Wenn Sie fragen: „Warum sind unsere Core Web Vitals im letzten Monat gesunken?“, plant der Agent möglicherweise drei Teilaufgaben: 1. PageSpeed-Daten überprüfen, 2. Analysetrends abrufen und 3. aktuelle Code-Bereitstellungen nachschlagen.

2. Abrufen: Der Agent durchsucht dynamisch mehrere Quellen.

Der Agent kann Ihr Dokumentindex abfragen, ein Dashboard scrapen, eine SQL-Abfrage ausführen oder eine Internetsuche durchführen. In diesem Schritt wird das Abrufen adaptiv: Wenn eine Quelle unvollständig ist, probiert er eine andere aus. Stellen Sie sich das wie einen Forscher vor, der sich nicht mit dem ersten Google-Ergebnis zufrieden gibt.

3. Begründen: Der Agent interpretiert und verknüpft das, was er gefunden hat.

Hier kommt die „Agentenfunktion” zum Tragen: Die KI vergleicht Datenpunkte, erkennt Widersprüche und schätzt Konfidenzniveaus. Wenn zwei Berichte miteinander in Konflikt stehen, markiert sie die Inkonsistenz, anstatt sie stillschweigend zusammenzuführen. Technisch gesehen beinhaltet dies iterative Aufforderungen und interne Bewertungen, was bedeutet, dass das Modell seine eigenen Zwischenantworten vor der endgültigen Synthese bewertet.

4. Handeln: Der Agent geht über die Textgenerierung hinaus.

Der Agent kann eine Berechnung durchführen, eine externe API aufrufen oder eine weitere Abfrage starten.

Beispiel: In der Marketing-Analytics kann der Agent die Traffic-Differenzen von Monat zu Monat anhand realer Zahlen berechnen, anstatt sie aus dem Text zu erraten.

Und die gute Nachricht: Aus diesem Grund integrieren viele Frameworks mittlerweile Funktionsaufruf-Ebenen, sodass der Agent die Ergebnisse überprüfen kann, anstatt zu halluzinieren.

5. Überprüfen: Der Agent überprüft die endgültige Argumentationskette.

Ein Meta-Schritt, in dem das Modell erneut bewertet, ob seine Beweise die Antwort stützen. Einige Systeme verwenden sogar Selbstkonsistenzprüfungen. Sie führen dieselbe Frage mehrmals aus, um zu sehen, ob die Schlussfolgerungen übereinstimmen. Wenn alle diese Phasen miteinander verbunden sind, wirkt das Ergebnis weniger wie ein „Chatbot-Text” und mehr wie ein intelligenter Mitarbeiter.

Zum Beispiel:

- Kundensupport: Anstatt einen FAQ-Absatz abzurufen, sammelt der Agent mehrere relevante Richtlinien, überprüft Daten und fasst die neuesten Bedingungen zusammen.

- Unternehmens-SEO: Der Agent ruft Ranking-Daten aus BigQuery ab, korreliert sie mit Crawl-Protokollen und schreibt eine kurze Diagnose zum Traffic-Verlust (mit verlinkten Belegen).

- Forschungs-Workflows: In der Pharma- oder Finanzbranche ruft er Dokumente oder Unterlagen ab, vergleicht Zahlen und markiert Anomalien automatisch.

Kurz gesagt:

Traditionelles RAG = Suche + Antwort.

Agentic RAG = Suche + Begründung + Handlung + Überprüfung.

Es ist wieder der Unterschied zwischen der Frage eines Bibliothekars nach einem Buch und einem ganzen Forschungsteam, das es liest, diskutiert und Ihnen eine fundierte Zusammenfassung liefert.

Warum es wichtig ist (Vorteile in der Praxis)

Was mich besonders beeindruckt, ist, dass die Schönheit von Agentic RAG nicht nur in der Technologie liegt, sondern in dem, was sie ermöglicht. Zum ersten Mal können große Sprachmodelle über statische Fragen und Antworten hinausgehen und sich wie intelligente Mitarbeiter verhalten, die Probleme durchdenken, ihre eigene Arbeit überprüfen und sich an neue Informationen anpassen.

Stellen wir uns einmal vor, wie das im wirklichen Leben aussehen könnte.

Was Agentic RAG wirklich verbessert

In einer klassischen RAG-Konfiguration improvisiert das Modell einfach, wenn Ihre Anfrage mehrdeutig ist oder die abgerufenen Daten unvollständig sind (hier beginnen die Halluzinationen).

Agentic RAG behebt dieses Problem. Die KI gibt nicht einfach auf, sondern plant einen weiteren Schritt. Sie kann die Frage umformulieren, eine weitere Suche durchführen oder Ergebnisse aus verschiedenen Datenbanken kombinieren, bis sie von der Antwort überzeugt ist.

Agentic RAG vertraut sich selbst nicht

Agentic RAG-Schleifen umfassen Schritte zum Schlussfolgern und Validieren, was bedeutet, dass die KI ihrem ersten Entwurf nicht vertraut. Sie kann mehrere Quellen gegenprüfen, widersprüchliche Fakten erkennen und Unsicherheitsgrade kennzeichnen.

Dadurch wird die KI von einem „probabilistischen Geschichtenerzähler” zu einem vorsichtigen Analysten, der tatsächlich weiß, wann er etwas nicht weiß.

Agentic RAG repliziert menschenähnliche Entscheidungsabläufe

Die größte Veränderung ist vielleicht konzeptioneller Natur: Agentic RAG spiegelt die Denkweise des Menschen wider.

Wir merken uns nicht alle Fakten, sondern erinnern uns, überprüfen und argumentieren anhand von Beweisen. Das ist es, was diese agentenbasierten Schleifen nachbilden – kontextuelles Denken auf Abruf.

Beispiel: Stellen Sie sich einen SEO-Intelligence-Agenten vor, der gefragt wird, warum die Konversionen im letzten Monat zurückgegangen sind. Anstatt einen Datensatz zu ziehen und zu raten, überprüft er automatisch die Google Search Console, ruft Metriken zur Seitengeschwindigkeit aus Lighthouse ab, vergleicht Datumsbereiche in GA4 und erstellt erst dann eine durch Beweise gestützte Narrative.

Agentisches RAG in Unternehmenskontexten mit Beispielen

Durch unsere Zusammenarbeit mit Unternehmen wissen wir, dass diese auf einem Meer von Daten sitzen. Sie verfügen über Analyse-Dashboards, CRM-Systeme, interne Wikis, Produktblätter, Richtliniendokumente und Kampagnenarchive. Sie kennen den Geburtstag Ihrer Mutter und das Datum, an dem Sie einen neuen Laptop kaufen.

Dennoch bleiben die meisten dieser Informationen unauffindbar (technisch gespeichert, aber praktisch vergessen).

RAG sollte das ändern

Es hat es vereinfacht, relevante Informationen abzurufen, aber das Abrufen allein löst das tiefer liegende Problem nicht. Unternehmen brauchen nicht nur Antworten, sondern Entscheidungen, die auf verifizierten, aktuellen Daten basieren. Hier kommt Agentic RAG ins Spiel.

So können Unternehmen Agentic RAG nutzen.

Beispiel 1: Agentic RAG kann bei der Kampagnenoptimierung helfen.

Jeder weiß, dass klassische Kampagnen oft erst nach dem Start überwacht und später ausgewertet werden.

Stellen Sie sich jetzt vor, dass Ihre Marketing-KI ständig alle relevanten Kennzahlen überwacht und bei Bedarf zusätzliche Informationen heranzieht, wie aktuelle Conversion-Daten, Web-Traffic oder sogar externe Signale wie Nachrichten aus dem Marktumfeld. Ihr Agentic RAG kann auf Basis dieser Daten sofort wie ein Marketing-Datenanalyst reagieren. Es kann vorschlagen, das Budget neu zu verteilen, besonders aktive Gruppen stärker anzusprechen oder A/B-Tests anzupassen, wenn sich neue Trends abzeichnen.

Beispiel 2: Agentic RAG kann bei der Gewinnung von Einblicken ins Geschäft helfen.

In großen Unternehmen sind Einblicke über mehrere Tools wie Google Analytics, Salesforce, Data Studio und interne SQL-Datenbanken verstreut. Ein von Agentic RAG unterstützter Assistent kann autonom Daten aus jeder Quelle abrufen, diese miteinander verknüpfen und Schlussfolgerungen aus den Ergebnissen ziehen.

Frage: „Was verursacht den Anstieg unserer Absprungrate auf Mobilgeräten?“

Der Agent könnte Core Web Vitals-Daten, Lighthouse-Metriken und GA-Sitzungen abrufen, eine Korrelation mit langsameren LCP-Zeiten feststellen und diese sogar anhand von Release-Protokollen validieren.

Beispiel 3: Unternehmens-SEO und Content Intelligence

Für SEO-Teams hilft RAG bereits bei strukturierten Datenprüfungen oder der Abfrage von Inhalten. Mit einer Agentur kann es jedoch selbstständig Leistungsverschiebungen diagnostizieren.

Ein Agentic RAG-System könnte beispielsweise:

- Ranking-Schwankungen für Suchanfragen zu „Reiseversicherungen“ erkennen,

- überprüfen, ob diese Seiten von einer AI Overview-Einführung betroffen waren,

- CWV-Metriken für diese URLs abrufen,

- historische Muster vergleichen

- und schließlich zusammenfassen:

Ihre LCP-Verschlechterung und Änderungen an internen Verlinkungen korrelieren mit einem Rückgang der Sichtbarkeit nach dem Update.

Beispiel 4: Kundensupport und Wissens-QA

Support-Teams in Unternehmen haben oft mit riesigen Stapeln Dokumentation zu tun, die häufig aktualisiert werden.

Ein Agentic RAG-Agent ruft nicht nur den ersten passenden Artikel ab, sondern überprüft auch, ob die Informationen aktuell sind, ob sich Richtlinien geändert haben und welche Ausnahmen gelten. Er kann sogar die Genauigkeit überprüfen, indem er interne APIs nach den neuesten Daten abfragt. Das Ergebnis ist ein schnellerer, kontextbezogener Support, der ohne erneutes Training von Modellen oder manuelles Taggen von Daten skaliert werden kann.

Beispiel Nr. 5: Wissensmanagement, das zurückdenkt

Eine Rechtsabteilung kann fragen: „Was hat sich zwischen 2022 und 2025 an unserer DSGVO-Richtlinie geändert?“ Anstatt zwei Dokumente auszugeben, führt das System einen Vergleich durch, markiert aktualisierte Klauseln und zitiert die genauen Quellen. Das ist ein kognitiver Sprung. Es ist ein Abruf, der begründet ist.

Kurz gesagt, Agentic RAG verwandelt Unternehmensdaten-Ökosysteme in lebendige Systeme, die über Silos hinweg denken, prüfen und handeln. Anstatt zu fragen: „Was sagen unsere Daten?“, beginnen Teams zu fragen: „Was bedeuten unsere Daten gerade und was sollten wir als Nächstes tun?“

Das ist der Unterschied zwischen Automatisierung und Intelligenz. Und genau hier beginnt Agentic RAG sich weniger wie ein Werkzeug und mehr wie ein Kollege anzufühlen.

Sprechen wir über Herausforderungen

Agentic RAG klingt leistungsstark (und ist es wahrscheinlich auch), aber es ist kein Allheilmittel. Jedes Mal, wenn Sie Autonomie hinzufügen, erhöhen Sie auch die Komplexität. Und Komplexität ist immer mit Kosten, Latenz und Risiken verbunden.

Schauen wir uns an, wo Dinge schiefgehen können (und oft auch schiefgehen).

Herausforderung Nr. 1: Garbage In, Garbage Out (gilt immer noch)

Anhand des Titels dieses Kapitels können Sie wahrscheinlich schon erahnen, worüber ich spreche.

Nun, RAG hängt vollständig von der Qualität Ihrer Daten ab. Wenn die zugrunde liegenden Dokumente veraltet, inkonsistent oder schlecht gegliedert sind, kann das System sich nicht aus diesem Durcheinander herausreden. Das Ergebnis sind lediglich noch überzeugendere Halluzinationen. Das bedeutet, dass es sich lohnt, vor dem Experimentieren mit Agentic RAG in eine ordentliche Datenhygiene zu investieren, wie z. B. eine klare Struktur, Metadaten-Tagging und eine konsistente Versionskontrolle. Schlussfolgerungen funktionieren nur, wenn die Abrufebene sie mit der Wahrheit füttert.

Herausforderung Nr. 2: Kontextdrift und Over-Looping

Eines der größten Probleme, die ich beim Testen von agentenbasierten Systemen beobachtet habe, ist Kontextdrift. Die KI entfernt sich nach und nach von der ursprünglichen Frage, während sie weiter plant, abruft und verfeinert.

In langen Argumentationsschleifen kann das Modell vergessen, was es eigentlich lösen wollte, und anfangen, Nebensächlichkeiten zu verfolgen.

Herausforderung Nr. 3: Latenz und Token-Kosten

Jeder Argumentationsschritt bedeutet einen weiteren API-Aufruf, eine weitere Abfrage und eine weitere Prompt-Erweiterung. Bei Bereitstellungen im Unternehmensmaßstab summiert sich das schnell.

Ohne Optimierungen wie Caching oder die Wiederverwendung von Einbettungen können agentenbasierte RAG-Pipelines langsam und teuer werden, insbesondere wenn Benutzer eine Interaktion in Echtzeit erwarten.

Herausforderung Nr. 4: Die Bewertung ist schwierig

In einer herkömmlichen RAG-Pipeline können Sie die Genauigkeit anhand der Abrufgenauigkeit und der Wiederauffindbarkeit messen.

Aber wie misst man die Qualität der Argumentation? Agentenbasierte Systeme stützen sich oft auf subjektive Bewertungen, wie z. B. menschliche Überprüfungen, Bewertungsrubriken oder synthetische QA-Datensätze. Das bedeutet, dass bis zur Ausreifung der Bewertungsrahmen die Schaffung robuster Feedback-Schleifen eine der größten Herausforderungen für die Einführung in Unternehmen bleibt.

Herausforderung Nr. 5: Risiko des Over-Engineerings

Nicht jedes Problem erfordert eine agentische Schleife. Manchmal ist eine einfache Abfrage- und Antwort-Konfiguration einer komplexen Argumentationskette überlegen, einfach weil sie schneller und einfacher zu warten ist. Ich habe Teams gesehen, die sich direkt in die Multi-Agenten-Orchestrierung gestürzt haben, bevor sie überhaupt eine saubere Datenpipeline hatten.

Der intelligentere Ansatz ist ein schrittweises Vorgehen. Beginnen Sie mit RAG, identifizieren Sie Fehlerquellen und fügen Sie nur dort Argumentationsschleifen hinzu, wo sie einen messbaren Mehrwert bieten.

So, wie geht es weiter? (Multi-Agent-RAG-Ökosysteme)

Agentisches RAG ist nur der erste Schritt auf dem Weg zu einer viel größeren Transformation, einer Welt, in der KI-Systeme nicht nur abrufen und argumentieren, sondern tatsächlich zusammenarbeiten.

Heute basieren die meisten Setups noch immer auf einem einzigen Agenten, der Planung, Abruf und Schlussfolgerung durchläuft. In naher Zukunft werden wir die Entstehung von Multi-Agent-Ökosystemen erleben. Das sind Netzwerke spezialisierter Agenten, die Speicher teilen, Ergebnisse der anderen überprüfen und sich auf komplexe Ziele hin koordinieren.

Stellen Sie sich ein Szenario in einem großen Unternehmen vor:

- Ein Agent konzentriert sich auf den Abruf von Inhalten aus internen Dokumentationen.

- Ein anderer Agent analysiert diese Daten und erkennt Widersprüche.

- Ein dritter aktualisiert die Wissensdatenbank, erstellt einen Bericht oder löst Warnmeldungen aus.

- Ein vierter überprüft das Endergebnis mithilfe eines separaten Schlussfolgerungsmodells oder einer externen API.

In der Praxis bedeutet das, dass Ihr Analyseassistent bald mit Ihrem SEO-Agenten, Ihrem CRM-Agenten und Ihrem Berichtsagenten kommunizieren könnte, wobei jeder innerhalb seines eigenen Bereichs Informationen abruft und Schlussfolgerungen zieht und sich dann auf eine gemeinsame Antwort abstimmt.

Diese Systeme werden sich von passiven Copiloten zu verteilten Schlussfolgerungsnetzwerken entwickeln, die mit Unsicherheiten umgehen, komplexe Arbeitsabläufe aufschlüsseln und sich durch Feedback selbst verbessern können.

Für Unternehmen sind die Auswirkungen enorm:

- Kontinuierliche Überwachung und Erklärung von KPIs.

- Sich selbst aktualisierende Dashboards, die lernen, was am wichtigsten ist.

- Interne Wissensgraphen, die über Abteilungen hinweg synchronisiert bleiben.

- Autonome Arbeitsabläufe, die die Lücke zwischen Erkenntnis und Handlung schließen.

Das ist keine Science-Fiction. Es ist die nächste logische Entwicklung, sobald Abruf, Schlussfolgerung und Handlungsfähigkeit zusammenkommen. Eine Zukunft, in der Maschinen nicht nur unsere Fragen beantworten, sondern uns helfen, bessere Fragen zu stellen. Nein, die Zukunft ist noch nicht geschrieben...

Zusammenfassung

Wenn klassisches RAG die Brücke zwischen Suche und Generierung war, dann ist Agentic RAG der Moment, in dem diese Brücke zum Leben erwacht. Es denkt, überprüft, handelt, und hilft dabei, Halluzinationen zu vermeiden und verwandelt die Informationsgewinnung in einen intelligenten Entscheidungsfluss. Dieser kleine Unterschied verändert alles: Genauigkeit, Vertrauen, Anpassungsfähigkeit und Umfang.

In Unternehmensumgebungen bedeutet dies den Übergang von statischen Chatbots zu dynamischen Intelligenzsystemen, die aus ihren eigenen Handlungen lernen. Das bedeutet weniger Halluzinationen, schnelleres Kontextverständnis und Erkenntnisse, die tatsächlich auf der Wahrheit basieren. Agentic RAG ersetzt menschliches Fachwissen nicht – es verstärkt es. Und genau das ist es, was wir bei Digital Loop entwickeln.

Wir haben maßgeschneiderte Enterprise-MarTech-Systeme entwickelt, die Daten aus Marketing-Tools, einschließlich Analysen, CRM, SEO-Plattformen, Anzeigen und mehr, in einer einzigen konsistenten Quelle der Wahrheit vereinen. Von dort aus ermöglicht uns unsere KI-Ebene, direkt mit den Daten zu kommunizieren. Wir können Fragen stellen, Anomalien erkennen oder neue Wachstumsmuster aufdecken – dank dialogorientierter KI-Schnittstellen, die auf unserem eigenen Talk-to-Data-Framework basieren.

Wenn Sie bereit sind, zu erfahren, wie Agentic RAG-Prinzipien Ihr Unternehmens-Marketing-Ökosystem optimieren können, lassen Sie uns darüber sprechen. Kontaktieren Sie uns, um zu erfahren, wie unsere maßgeschneiderten MarTech-Lösungen Ihnen helfen können, komplexe Daten in umsetzbare Informationen zu verwandeln.